PSG系列弹簧圆锥破碎机-郑州双优重工

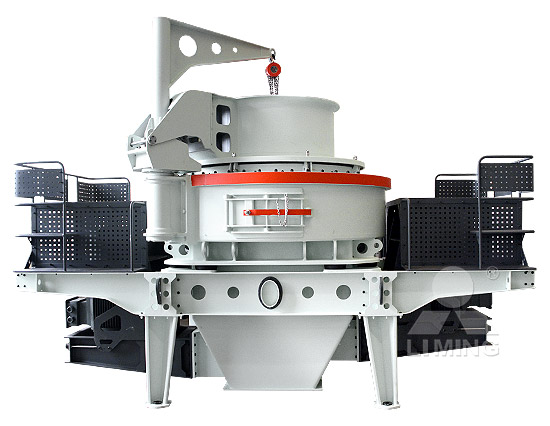

双优重工psg系列弹簧圆锥破碎机介绍——大多用于二破,产品粒型优异! psg系列弹簧圆锥破碎机是郑州双优重工有效公司在引进美国西蒙斯圆锥技术的基础上,结合30多年实践 PSG系列弹簧圆锥破碎机-郑州双优重工双优重工psg系列弹簧圆锥破碎机介绍——大多用于二破,产品粒型优异! psg系列弹簧圆锥破碎机是郑州双优重工有效公司在引进美国西蒙斯圆锥技术的基础上,结合30多年实践

了解更多

PSGD-1310圆锥机型号与参数表-西蒙斯簧圆锥破碎机-中誉

psgd-1310相关文章. 砖瓦破碎机有哪些?大概价位是多少? 由于资源化凭借技术的发展,废旧砖头、砖渣等项目废料、废弃混凝土通过破碎、粉碎、筛选分级处置,可以普遍的用 PSGD-1310圆锥机型号与参数表-西蒙斯簧圆锥破碎机-中誉psgd-1310相关文章. 砖瓦破碎机有哪些?大概价位是多少? 由于资源化凭借技术的发展,废旧砖头、砖渣等项目废料、废弃混凝土通过破碎、粉碎、筛选分级处置,可以普遍的用

了解更多

PSG型圆锥破-圆锥式破碎机-产品库-环球破碎机网

焦作中鑫重工专业从事psg型圆锥破的生产、销售。找psg型圆锥破,找圆锥式破碎机上焦作中鑫重工,psg型圆锥破价格,所在地河南焦作。 PSG型圆锥破-圆锥式破碎机-产品库-环球破碎机网焦作中鑫重工专业从事psg型圆锥破的生产、销售。找psg型圆锥破,找圆锥式破碎机上焦作中鑫重工,psg型圆锥破价格,所在地河南焦作。

了解更多

圆锥式破碎机型号、参数解析

3.弹簧圆锥式破碎机型号、参数. 进料粒度:≤300mm 处理能力:15-600t/h. 弹簧圆锥破碎机常见的型号有PYB-600 PYD-600 PYB-900 PYB-1200 PYB-1750 PYB 圆锥式破碎机型号、参数解析 3.弹簧圆锥式破碎机型号、参数. 进料粒度:≤300mm 处理能力:15-600t/h. 弹簧圆锥破碎机常见的型号有PYB-600 PYD-600 PYB-900 PYB-1200 PYB-1750 PYB

了解更多

圆锥式破碎机

分享. 收藏. 破碎玄武岩用哪种圆锥破比较好?. 小不点. 单缸圆锥破碎机。. 单缸圆锥破碎机一般具有破碎效能高、操作简单、运行成本较低、节能降耗、绿色环保、维修方便。. 1、 圆锥式破碎机 分享. 收藏. 破碎玄武岩用哪种圆锥破比较好?. 小不点. 单缸圆锥破碎机。. 单缸圆锥破碎机一般具有破碎效能高、操作简单、运行成本较低、节能降耗、绿色环保、维修方便。. 1、

了解更多

CN104549635B 圆锥式破碎机 Google Patents

圆锥式破碎机 Download PDF Info Publication number CN104549635B. CN104549635B CN201510042028.6A CN201510042028A CN104549635B CN 104549635 B CN104549635B 圆锥式破碎机 Google Patents圆锥式破碎机 Download PDF Info Publication number CN104549635B. CN104549635B CN201510042028.6A CN201510042028A CN104549635B CN 104549635 B

了解更多

CN204448124U 圆锥式破碎机 Google Patents

圆锥式破碎机,包括机架,以及设置在机架内部的传动机构、偏心机构、动锥组和动锥防逆旋机构;所述机架包括下部机架和上部机架;该下部机架内部空间设计合理,润滑油路汇 CN204448124U 圆锥式破碎机 Google Patents圆锥式破碎机,包括机架,以及设置在机架内部的传动机构、偏心机构、动锥组和动锥防逆旋机构;所述机架包括下部机架和上部机架;该下部机架内部空间设计合理,润滑油路汇

了解更多

PSG系列圆锥破碎机 搜狗百科

psg系列圆锥破碎机是在传统破碎机基础上研发出来的新型 破碎机,,适用于破碎中等和中等以上硬度的各种矿石和岩石,广泛应用在冶金工业、建材工业、筑路 PSG系列圆锥破碎机 搜狗百科psg系列圆锥破碎机是在传统破碎机基础上研发出来的新型 破碎机,,适用于破碎中等和中等以上硬度的各种矿石和岩石,广泛应用在冶金工业、建材工业、筑路

了解更多

圆锥破碎机都有哪些种类?

目前市场上主流的有5种,分别是: 1、西蒙斯圆锥破 西蒙斯圆锥破主要作为中、细碎机,由于价格低廉,性能比较稳定,用户使用维护方面的经验也比较普及,用在对产品粒度要 圆锥破碎机都有哪些种类? 目前市场上主流的有5种,分别是: 1、西蒙斯圆锥破 西蒙斯圆锥破主要作为中、细碎机,由于价格低廉,性能比较稳定,用户使用维护方面的经验也比较普及,用在对产品粒度要

了解更多

模型量化进展长文综述(六)-训练过程

将梯度进行scale,scale值取决于权重的位置,在原始权重空间中应用PSGD等效于在扭曲空间中通过标准SGD优化权重,原始空间中的权重通过可逆函数进行扭曲。 可逆扭曲函数经过设计,可以通过缩放梯度来迫使原始空间 模型量化进展长文综述(六)-训练过程 将梯度进行scale,scale值取决于权重的位置,在原始权重空间中应用PSGD等效于在扭曲空间中通过标准SGD优化权重,原始空间中的权重通过可逆函数进行扭曲。 可逆扭曲函数经过设计,可以通过缩放梯度来迫使原始空间

了解更多

圆锥破碎机_百度百科

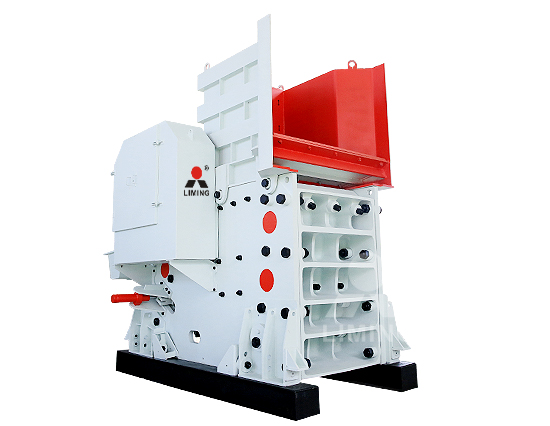

圆锥破碎机一种适用于冶金、建筑、筑路、化学及硅酸盐行业中原料的破碎机械。根据破碎原理的不同和产品颗粒大小不同,又分为很多型号。破碎机广泛运用于矿山、冶炼、建材、公路、铁路、水利和化学工业等众多部门。圆锥破碎机破碎比大、效率高、能耗低,产品粒度均匀,适合中碎和细碎 圆锥破碎机_百度百科圆锥破碎机一种适用于冶金、建筑、筑路、化学及硅酸盐行业中原料的破碎机械。根据破碎原理的不同和产品颗粒大小不同,又分为很多型号。破碎机广泛运用于矿山、冶炼、建材、公路、铁路、水利和化学工业等众多部门。圆锥破碎机破碎比大、效率高、能耗低,产品粒度均匀,适合中碎和细碎

了解更多

ICML 获奖者陆昱成:去中心化机器学习的理论极限在

d-psgd是扩展随机梯度下降(sgd)最基本算法之一,也是应用于协议层的一种典型去中心化算法,可实现线性并行加速。 虽然学术界已有一些成熟的去中心化算法,但落地工业级别的去中心化系统仍处于初步阶段。 ICML 获奖者陆昱成:去中心化机器学习的理论极限在d-psgd是扩展随机梯度下降(sgd)最基本算法之一,也是应用于协议层的一种典型去中心化算法,可实现线性并行加速。 虽然学术界已有一些成熟的去中心化算法,但落地工业级别的去中心化系统仍处于初步阶段。

了解更多

梯度下降法(SGD)原理解析及其改进优化算法

梯度下降 2. 梯度下降法迭代步骤 梯度下降的一个直观的解释: 比如我们在一座大山上的某处位置,由于我们不知道怎么下山,于是决定走一步算一步,也就是在每走到一个位置的时候,求解当前位置的梯度,沿着梯度的负方向,也就是当前最陡峭的位置向下走一步,然后继续求解当前位置梯度,向 梯度下降法(SGD)原理解析及其改进优化算法 梯度下降 2. 梯度下降法迭代步骤 梯度下降的一个直观的解释: 比如我们在一座大山上的某处位置,由于我们不知道怎么下山,于是决定走一步算一步,也就是在每走到一个位置的时候,求解当前位置的梯度,沿着梯度的负方向,也就是当前最陡峭的位置向下走一步,然后继续求解当前位置梯度,向

了解更多

EAPC Wiki Unitat 2. L’expedient administratiu digital

2.4.1.1 La digitalització a les oficines d’atenció ciutadana. En la unitat 1 es determina la funció essencial de les oficines d’atenció ciutadana respecte a garantir que l’expedient administratiu tingui format electrònic des de l'inici, que és la digitalització dels documents en format paper que les persones interessades aporten en EAPC Wiki Unitat 2. L’expedient administratiu digital2.4.1.1 La digitalització a les oficines d’atenció ciutadana. En la unitat 1 es determina la funció essencial de les oficines d’atenció ciutadana respecte a garantir que l’expedient administratiu tingui format electrònic des de l'inici, que és la digitalització dels documents en format paper que les persones interessades aporten en

了解更多

南加州大学钱学海:去中心化分布式训练系统的最新

如果直接按照ad-psgd算法来实现原子性操作,在分布式系统中性能会受到很大影响,具体表现在两个方面:原子性操作会导致大量同步成本。 如图13(a)中的实验结果所示,在整个训练过程中,AD-PSGD在不同的数据集上训练的同步开销都比Ring All-Reduce要大。 南加州大学钱学海:去中心化分布式训练系统的最新如果直接按照ad-psgd算法来实现原子性操作,在分布式系统中性能会受到很大影响,具体表现在两个方面:原子性操作会导致大量同步成本。 如图13(a)中的实验结果所示,在整个训练过程中,AD-PSGD在不同的数据集上训练的同步开销都比Ring All-Reduce要大。

了解更多

arXiv:1807.06629v3 [math.OC] 16 Nov 2018

PSGD requires each worker to exchange their local solu-tions/gradients with its neighbors at every iteration, the total number of communication rounds in D-PSGD is the same as that in parallel mini-batch SGD. Another notable method to reduce communication overhead in parallel mini-batch SGD is to let each worker use compressed gradients rather than arXiv:1807.06629v3 [math.OC] 16 Nov 2018PSGD requires each worker to exchange their local solu-tions/gradients with its neighbors at every iteration, the total number of communication rounds in D-PSGD is the same as that in parallel mini-batch SGD. Another notable method to reduce communication overhead in parallel mini-batch SGD is to let each worker use compressed gradients rather than

了解更多

Can Decentralized Algorithms Outperform Centralized Algorithms

PSGD algorithm and provide the first theoretical analysis that indicates a regime in which decentralized algorithms might outperform centralized algorithms for distributed stochastic gradient descent. This is because D-PSGD has comparable total computational complexities to C-PSGD but requires much less communication cost on the busiest node. Can Decentralized Algorithms Outperform Centralized AlgorithmsPSGD algorithm and provide the first theoretical analysis that indicates a regime in which decentralized algorithms might outperform centralized algorithms for distributed stochastic gradient descent. This is because D-PSGD has comparable total computational complexities to C-PSGD but requires much less communication cost on the busiest node.

了解更多

多大获杰出论文奖,田渊栋、陆昱成获荣誉提名,ICML

刚刚,ICML 2021揭晓了本届杰出论文奖和杰出论文荣誉提名奖,来自多伦多大学、谷歌大脑的研究获得了杰出论文奖,包括田渊栋、陆昱成在内的多位学者获得了杰出论文荣誉提名奖。. 此外,高通副总裁Max Welling和Hinton学生郑宇怀合著的研究获得了本次大会的时间 多大获杰出论文奖,田渊栋、陆昱成获荣誉提名,ICML刚刚,ICML 2021揭晓了本届杰出论文奖和杰出论文荣誉提名奖,来自多伦多大学、谷歌大脑的研究获得了杰出论文奖,包括田渊栋、陆昱成在内的多位学者获得了杰出论文荣誉提名奖。. 此外,高通副总裁Max Welling和Hinton学生郑宇怀合著的研究获得了本次大会的时间

了解更多

Asynchronous Decentralized Parallel Stochastic Gradient Descent

In AD-PSGD, workers do not wait for all others and only communicate in a decentralized fashion. AD-PSGD can achieve linear speedup with respect to the number of workers and admit a convergence rate of O(1= p K), where K is the number of updates. This rate is consistent with D-PSGD and cen-tralized parallel SGD. By design, AD-PSGD enables wait- Asynchronous Decentralized Parallel Stochastic Gradient DescentIn AD-PSGD, workers do not wait for all others and only communicate in a decentralized fashion. AD-PSGD can achieve linear speedup with respect to the number of workers and admit a convergence rate of O(1= p K), where K is the number of updates. This rate is consistent with D-PSGD and cen-tralized parallel SGD. By design, AD-PSGD enables wait-

了解更多

Distributed Optimization SpringerLink

The AD-PSGD scheme exhibits linear speedup with increasing number of nodes under the assumption that the data across nodes is independent and homogeneously distributed. If the expected time to communicate a newly obtained gradient estimate exceeds the expected time to compute such estimate on any local node, a federated (or a Distributed Optimization SpringerLinkThe AD-PSGD scheme exhibits linear speedup with increasing number of nodes under the assumption that the data across nodes is independent and homogeneously distributed. If the expected time to communicate a newly obtained gradient estimate exceeds the expected time to compute such estimate on any local node, a federated (or a

了解更多

【NIPS 2020】分布式SGD下的自适应梯度量化

下面主要介绍NIPS2020中一篇关于分布式SGD自适应梯度量化的论文:Adaptive Gradient Quantization for Data-Parallel SGD. 梯度量化有一个固定模式,将连续的梯度取值空间映射到一个离散的集合上。. 以经典 【NIPS 2020】分布式SGD下的自适应梯度量化 下面主要介绍NIPS2020中一篇关于分布式SGD自适应梯度量化的论文:Adaptive Gradient Quantization for Data-Parallel SGD. 梯度量化有一个固定模式,将连续的梯度取值空间映射到一个离散的集合上。. 以经典

了解更多

Abstract arXiv:2002.01119v1 [cs.LG] 4 Feb 2020

SGD (AD-PSGD) [2] have been applied to a broad variety of deep learning tasks. Compared to S-PSGD, (A)D-PSGD replaces global weight synchronization with model averaging among neighboring learners in a peer-to-peer fashion while achieving the same convergence rate. In [3], AD-PSGD was first applied to automatic speech recognition Abstract arXiv:2002.01119v1 [cs.LG] 4 Feb 2020SGD (AD-PSGD) [2] have been applied to a broad variety of deep learning tasks. Compared to S-PSGD, (A)D-PSGD replaces global weight synchronization with model averaging among neighboring learners in a peer-to-peer fashion while achieving the same convergence rate. In [3], AD-PSGD was first applied to automatic speech recognition

了解更多

D-(DP)2SGD: Decentralized Parallel SGD with Differential Privacy

In D-PSGD, all nodes compute the stochastic gradient using their local dataset and exchange the results with their neighbors iteratively. However, in fact, dynamicity has been an important feature for networks, especially for large-scale networks, such as IoT [ 10 ] and V2V networks [ 11,12 ], as nodes in the network can move D-(DP)2SGD: Decentralized Parallel SGD with Differential Privacy In D-PSGD, all nodes compute the stochastic gradient using their local dataset and exchange the results with their neighbors iteratively. However, in fact, dynamicity has been an important feature for networks, especially for large-scale networks, such as IoT [ 10 ] and V2V networks [ 11,12 ], as nodes in the network can move

了解更多

EAPC Wiki 3. La gestió documental dels documents electrònics

La gestió documental dels documents electrònics. Introducció. 3.1 El protocol de gestió de documents electrònics i arxiu de la Generalitat. 3.2 Els grups de treball multidisciplinaris de gestió documental. 3.3 L'arxiu electrònic. 3.4 El sistema general de gestió de la documentació administrativa aplicat als documents electrònics. EAPC Wiki 3. La gestió documental dels documents electrònicsLa gestió documental dels documents electrònics. Introducció. 3.1 El protocol de gestió de documents electrònics i arxiu de la Generalitat. 3.2 Els grups de treball multidisciplinaris de gestió documental. 3.3 L'arxiu electrònic. 3.4 El sistema general de gestió de la documentació administrativa aplicat als documents electrònics.

了解更多

ICML 获奖者陆昱成:去中心化机器学习的理论极限在

在这篇论文中,他主要研究了去中心化算法的理论极限, 通过对D-PSGD(罗切斯特大学Ji Liu团队提出)和SGP(Facebook AI Lab提出)等经典算法的系统性 ICML 获奖者陆昱成:去中心化机器学习的理论极限在在这篇论文中,他主要研究了去中心化算法的理论极限, 通过对D-PSGD(罗切斯特大学Ji Liu团队提出)和SGP(Facebook AI Lab提出)等经典算法的系统性

了解更多

ICML 2018 腾讯AI Lab详解16篇入选论文-CSDN博客

PSGD的Tensorflow实现 概述 PSGD(预处理随机梯度下降)是一种通用的二阶优化方法。 PSGD通过其固有的处理非凸性和梯度噪声的能力使其与大多数现有方法有所不同。 请参考的设计思想。 已存档。 此更新的实现适用于tf2.x,并且还大大简化了Kronecker产品预处理器的 ICML 2018 腾讯AI Lab详解16篇入选论文-CSDN博客PSGD的Tensorflow实现 概述 PSGD(预处理随机梯度下降)是一种通用的二阶优化方法。 PSGD通过其固有的处理非凸性和梯度噪声的能力使其与大多数现有方法有所不同。 请参考的设计思想。 已存档。 此更新的实现适用于tf2.x,并且还大大简化了Kronecker产品预处理器的

了解更多

「隐语小课」深度学习下的DP-SGD-CSDN博客

隐语SecretFlow. 文章浏览阅读545次。. 前言:基于差分隐私随机梯度下降法 (DP-SGD) 是深度学习中最流行的 DP 训练方法,与传统的随机梯度下降算法(SGD)的主要不同点是:DP-SGD算法在每一轮迭代过程中都会进行梯度裁剪和添加高斯噪声。. 本篇内容将对深度学习下 「隐语小课」深度学习下的DP-SGD-CSDN博客隐语SecretFlow. 文章浏览阅读545次。. 前言:基于差分隐私随机梯度下降法 (DP-SGD) 是深度学习中最流行的 DP 训练方法,与传统的随机梯度下降算法(SGD)的主要不同点是:DP-SGD算法在每一轮迭代过程中都会进行梯度裁剪和添加高斯噪声。. 本篇内容将对深度学习下

了解更多

L,CORRECT GLOBALLY A DISTRIBUTED ALGORITHM FOR

SGD with Periodic Averaging (PSGD-PA (Dean et al.,2012;Li et al.,2020b)) suffers from sig-nificant accuracy drop and cannot achieve the same accuracy as the single machine training, even by increasing the number of communica-tion. However, Global Graph Sampling (GGS) can successfully reach the baseline by consider- L,CORRECT GLOBALLY A DISTRIBUTED ALGORITHM FOR SGD with Periodic Averaging (PSGD-PA (Dean et al.,2012;Li et al.,2020b)) suffers from sig-nificant accuracy drop and cannot achieve the same accuracy as the single machine training, even by increasing the number of communica-tion. However, Global Graph Sampling (GGS) can successfully reach the baseline by consider-

了解更多

(三) DP-SGD 算法解释 jasonzhangxianrong 博客园

For this reason, it would be much preferable if we could instead insert the DP mechanism during model training, so that the resulting model could be safe for release. This brings us to the DP-SGD algorithm. (There is evidence that even when you only care about accuracy, private training still beats private prediction. (三) DP-SGD 算法解释 jasonzhangxianrong 博客园For this reason, it would be much preferable if we could instead insert the DP mechanism during model training, so that the resulting model could be safe for release. This brings us to the DP-SGD algorithm. (There is evidence that even when you only care about accuracy, private training still beats private prediction.

了解更多

Plataforma de Serveis de Gestió Documental

PSGD Manual d’integració Febrer 2017 Versió 6.0 Versions Data Versió Descripció 01/10/2014 1.0 13/10/2014 2.0 30/10/2014 3.0 01/12/2014 4.0 12/02/2015 5.0 10/03/2015 5.1 18/09/2015 5.2 Recomanar com a bones practiques la revisió d’un document creat si al BO li ha retornat timeout en la crida Plataforma de Serveis de Gestió DocumentalPSGD Manual d’integració Febrer 2017 Versió 6.0 Versions Data Versió Descripció 01/10/2014 1.0 13/10/2014 2.0 30/10/2014 3.0 01/12/2014 4.0 12/02/2015 5.0 10/03/2015 5.1 18/09/2015 5.2 Recomanar com a bones practiques la revisió d’un document creat si al BO li ha retornat timeout en la crida

了解更多

AAAI 2020 基于随机路径积分的差分估计子的去中心化

Xiangru Lian 等提出的去中心化并行的随机梯度下降(D-PSGD)[2] 取得了和有中心并行的随机梯度下降相近的收敛率。 在本文中,我们将基于随机路径积分的差分估计子非凸优化方法推广到去中心化分布式计算场景中, AAAI 2020 基于随机路径积分的差分估计子的去中心化Xiangru Lian 等提出的去中心化并行的随机梯度下降(D-PSGD)[2] 取得了和有中心并行的随机梯度下降相近的收敛率。 在本文中,我们将基于随机路径积分的差分估计子非凸优化方法推广到去中心化分布式计算场景中,

了解更多

ICML 2018 腾讯AI Lab详解16篇入选论文

研究者在这篇论文中提出了一种异步去中心化并行随机梯度下降(ad-psgd),能在异构环境中表现稳健且通信效率高并能维持最佳的收敛速率。 理论分析表明 AD-PSGD 能以和 SGD 一样的最优速度收敛,并且能随工作器的数量线性提速。 ICML 2018 腾讯AI Lab详解16篇入选论文 研究者在这篇论文中提出了一种异步去中心化并行随机梯度下降(ad-psgd),能在异构环境中表现稳健且通信效率高并能维持最佳的收敛速率。 理论分析表明 AD-PSGD 能以和 SGD 一样的最优速度收敛,并且能随工作器的数量线性提速。

了解更多

美国南加州大学骆沁毅:构建高性能的异构分布式

而AD-PSGD则可以很好地抵抗Straggler问题,从而在同构和异构平台上表现出相当的性能。但是AD-PSGD也有其明显的短板。当应用在没有Straggler的同构平台上时,其性能明显低于All-Reduce。这是由于AD-PSGD中模型参数平均化操作的原子性所带来的大量开销导致的。 美国南加州大学骆沁毅:构建高性能的异构分布式而AD-PSGD则可以很好地抵抗Straggler问题,从而在同构和异构平台上表现出相当的性能。但是AD-PSGD也有其明显的短板。当应用在没有Straggler的同构平台上时,其性能明显低于All-Reduce。这是由于AD-PSGD中模型参数平均化操作的原子性所带来的大量开销导致的。

了解更多

复杂型创伤后应激障碍(complex PTSD)与过去定义的PTSD

从ICD11角度来说,CPTSD的病人肯定可以被诊断为PTSD,但不是所有PTSD病人都可以被诊断为CPTSD(区别在于创伤经历是否发生在成年前、创伤是否长期和频繁,同时病人是否体验到CPTSD有而PTSD没有的 病症 )。. 在目前的医疗系统里,CPTSD依然可以当作PTSD来诊断和治疗 复杂型创伤后应激障碍(complex PTSD)与过去定义的PTSD从ICD11角度来说,CPTSD的病人肯定可以被诊断为PTSD,但不是所有PTSD病人都可以被诊断为CPTSD(区别在于创伤经历是否发生在成年前、创伤是否长期和频繁,同时病人是否体验到CPTSD有而PTSD没有的 病症 )。. 在目前的医疗系统里,CPTSD依然可以当作PTSD来诊断和治疗

了解更多

Network-Density-Controlled Decentralized Parallel Stochastic Gradient

PSGD) [7], which is one of the state-of-the-art algorithms for decentralized learning, as a reference algorithm for our discussion. Wang et al. [8] formulated a relationship between network density and the performance of D-PSGD. They an-alyzed the performance of D-PSGD from the perspective of computation of the average squared gradient norm of Network-Density-Controlled Decentralized Parallel Stochastic GradientPSGD) [7], which is one of the state-of-the-art algorithms for decentralized learning, as a reference algorithm for our discussion. Wang et al. [8] formulated a relationship between network density and the performance of D-PSGD. They an-alyzed the performance of D-PSGD from the perspective of computation of the average squared gradient norm of

了解更多

k arXiv:1705.09056v5 [math.OC] 11 Sep 2017

Algorithm 1 Decentralized Parallel Stochastic Gradient Descent (D-PSGD) on the ith node Require: initial point x0,i = x0, step length g,weight matrix W,and number of iterations K 1: for k = 0,1,2,..., K 1 do 2: Randomly sample xk,i from local data of the i-th node 3: Compute a local stochastic gradient based on xk,i and current optimization variable k,i: r Fi(k,i; k,i) k arXiv:1705.09056v5 [math.OC] 11 Sep 2017Algorithm 1 Decentralized Parallel Stochastic Gradient Descent (D-PSGD) on the ith node Require: initial point x0,i = x0, step length g,weight matrix W,and number of iterations K 1: for k = 0,1,2,..., K 1 do 2: Randomly sample xk,i from local data of the i-th node 3: Compute a local stochastic gradient based on xk,i and current optimization variable k,i: r Fi(k,i; k,i)

了解更多

Tensorflow 和PyTorch的区别对比,哪个更好?

第 4 点:. Tensorflow 的社区比 PyTorch 大得多。. 这意味着更容易找到学习 Tensorflow 的资源,也更容易找到问题的解决方案。. 另外,小普还注意到,许多教程和 MOOC 都涵盖了Tensorflow,这是因为与 Tensorflow 相比,PyTorch 是一个相对较新的框架。. 所以,在资 Tensorflow 和PyTorch的区别对比,哪个更好? 第 4 点:. Tensorflow 的社区比 PyTorch 大得多。. 这意味着更容易找到学习 Tensorflow 的资源,也更容易找到问题的解决方案。. 另外,小普还注意到,许多教程和 MOOC 都涵盖了Tensorflow,这是因为与 Tensorflow 相比,PyTorch 是一个相对较新的框架。. 所以,在资

了解更多

DP-SGD这个算法具体是怎么被应用的呢,直接调用privacy

DP-SGD(Differentially Private Stochastic Gradient Descent)算法是一种应用 差分隐私 保护隐私的机器学习算法,它可以被应用于深度学习任务中。. 在使用DP-SGD时,需要在优化器中添加一些隐私相关的操作来确保模型的隐私性。. 具体来说, PyTorch中privacy.optimizers模块提供了 DP-SGD这个算法具体是怎么被应用的呢,直接调用privacyDP-SGD(Differentially Private Stochastic Gradient Descent)算法是一种应用 差分隐私 保护隐私的机器学习算法,它可以被应用于深度学习任务中。. 在使用DP-SGD时,需要在优化器中添加一些隐私相关的操作来确保模型的隐私性。. 具体来说, PyTorch中privacy.optimizers模块提供了

了解更多